Promowanie fikcyjnej inwestycji

W marcu 2024 roku ponownie rozgorzały dyskusje na temat oszustw związanych z technologią deepfake. Na Facebooku pojawiły się filmy, w których użyto wizerunku prezesa InPostu do promowania fikcyjnych inwestycji. Rafał Brzoska szybko zareagował, zgłaszając problem administratorom Meta, lecz mimo jego zdecydowanych protestów, serwis przez wiele dni nie podjął żadnych działań. W tych filmach oszuści zastosowali technikę lip-sync, polegającą na manipulacji głosem i synchronizacji ruchu ust osoby występującej na nagraniu z fałszywą treścią.

- Technologie umożliwiają obecnie przestępcom łatwe manipulacje materiałami audiowizualnymi. W przypadku technologii typu „text-to-speech”, wystarczy im zaledwie kilka sekund nagranego głosu, aby stworzyć nowy podkład dźwiękowy, który może być zsynchronizowany z materiałem wideo, na przykład z dowolnego przemówienia czy wiecu politycznego – powiedziała Ewelina Bartuzi-Trokielewicz, kierująca w NASK Zespołem Analizy Deepfake.

- Dla technologii „speech-to-speech”, w której intonacja, emocje zawarte w głosie są bardziej złożone, do wykonania podróbki potrzebny jest dłuższy fragment, około jednej minuty oryginalnego materiału – dodała.

Wzrost oszustw

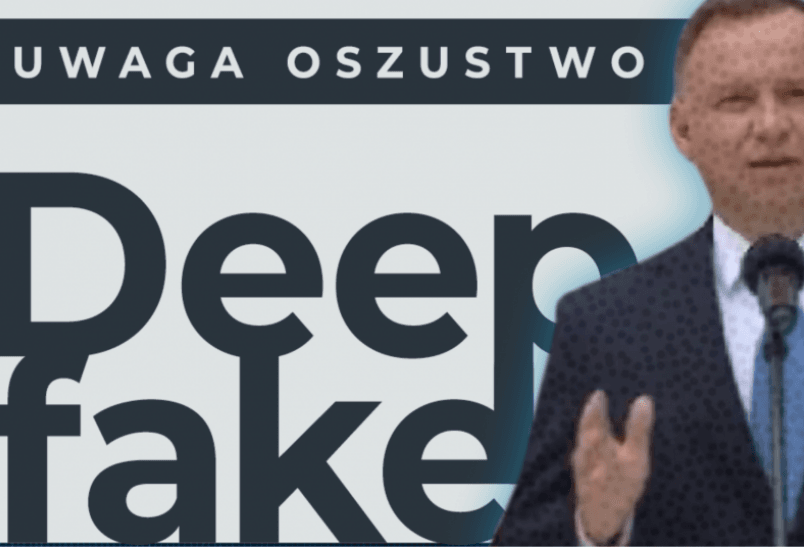

Od początku maja na platformach społecznościowych zaobserwowano liczne nowe oszustwa typu deepfake. Cyberprzestępcy nielegalnie posłużyli się wizerunkami i podrobionymi głosami takich osób jak prezydent Andrzej Duda, minister zdrowia Izabela Leszczyna, piłkarz Robert Lewandowski, influencer Kamil Labudda (Budda) oraz prezes InPostu Rafał Brzoska. Każda znana osoba, która ma autorytet w określonych grupach społecznych – w tym politycy, biznesmeni i celebryci – jest narażona na takie działania.typu deepfake.

Przestępcy nielegalnie wykorzystali wizerunki i podrobili głosy takich osób jak prezydent Andrzej Duda, minister zdrowia Izabela Leszczyna, piłkarz Robert Lewandowski, influencer Kamil Labudda (Budda) oraz prezes InPostu, Rafał Brzoska. Kradzież wizerunku i głosu grozi każdemu, kto jest znany i cieszy się autorytetem w określonych kręgach społecznych – dotyczy to polityków, biznesmenów oraz celebrytów.

- Łatwość, z jaką można stworzyć fałszywe materiały audiowizualne, zwiększa ryzyko manipulacji i dezinformacji. Dlatego istotne jest zwiększenie świadomości społecznej na temat rozwoju i możliwości technologii generowania treści syntetycznych. Użytkownicy mediów społecznościowych powinni ostrożnie podchodzić do treści wideo, które wydają się niezweryfikowane lub podejrzane. Dotyczy to zwłaszcza tych materiałów, które mają potencjalny wpływ na publiczne postrzeganie znaczących postaci i instytucji – przestrzega ekspertka NASK.